有时候在eclipse上运行项目,需要引用的Hadoop的jar包,也就是hadoop的外部依赖包,有conf,fs,io,mapreduce等等,这里列举了一部分,基本上hadoop的所有外部依赖jar包都包含在内了,如果下载了不会使用,可以看我...

”hadoop jar包 外部依赖“ 的搜索结果

有时候在eclipse上运行项目,需要引用的Hadoop的jar包,这里总结了一个很有用的小技巧 首先需要下载Hadoop的安装包 这里我直接分享一个官网hadoop的一个版本的下载链接: ...

一般来说hadoop命令执行jar包需要在hadoop的bin路径下执行命令如下:./hadoop jar xx.jar mainclassname inputpath outputpath对于XX.jar包中本身编译需要外部jar包的情况,则需要在封装成xx.jar包时候把所有外部jar...

-cp 和 -classpath 一样,是指定类运行所依赖其他类的路径,通常是类库,jar包之类,需要全路径到jar包,window上分号“;”java -cp .;myClass.jar packname.mainclassnameclasspath中的jar文件能使用通配符,如果是...

aws-java-sdk-1.7.4.jar hadoop-aws-2.7.2.jar 引入代码即可在读写中国区亚马逊s3

ambari集成impala-3.0.0依赖cdh版本的hadoop-hbase-hive相关jar包,查hive外部表(基于hbase)

在hadoop平台上写了一个mapreduce程序,jar包运行时总是报NoClassDefFoundError错误,我是通过maven方式导入的jar包。解决办法:将maoreduce程序打成的jar包里新建一个lib文件夹,里面放上需要的第三方jar包,再运行...

/bin/bash#JDK所在路径JAVA_HOME="/home/hadoop/software/jdk1.7.0_51"#Java程序所在的目录(classes的上一级目录)APP_HOME=/home/hadoop/myapp#需要启动的Java主程序(main方法类) (需要执行的代码需要达成jar包放到...

hadoop引用外部jar包有两种方式: 第一:实用-libjars 第二:在程序中通过tmpjars参数设定 job.getConfiguration().set("tmpjars",jars); jars为所有外部jar包字符串形式,英文逗号分隔。 在运行...

#问题描述使用hadoop命令执行hbase应用jar包时,报如下错误:[hadoop@ breath ~]$ hadoop jar ~/HbaseTest-0.1.jar Test.HtableCreate Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/...

flink安装所需要的第三方jar,即flink-shaded-hadoop-2-uber-2.7.5-10.0.jar

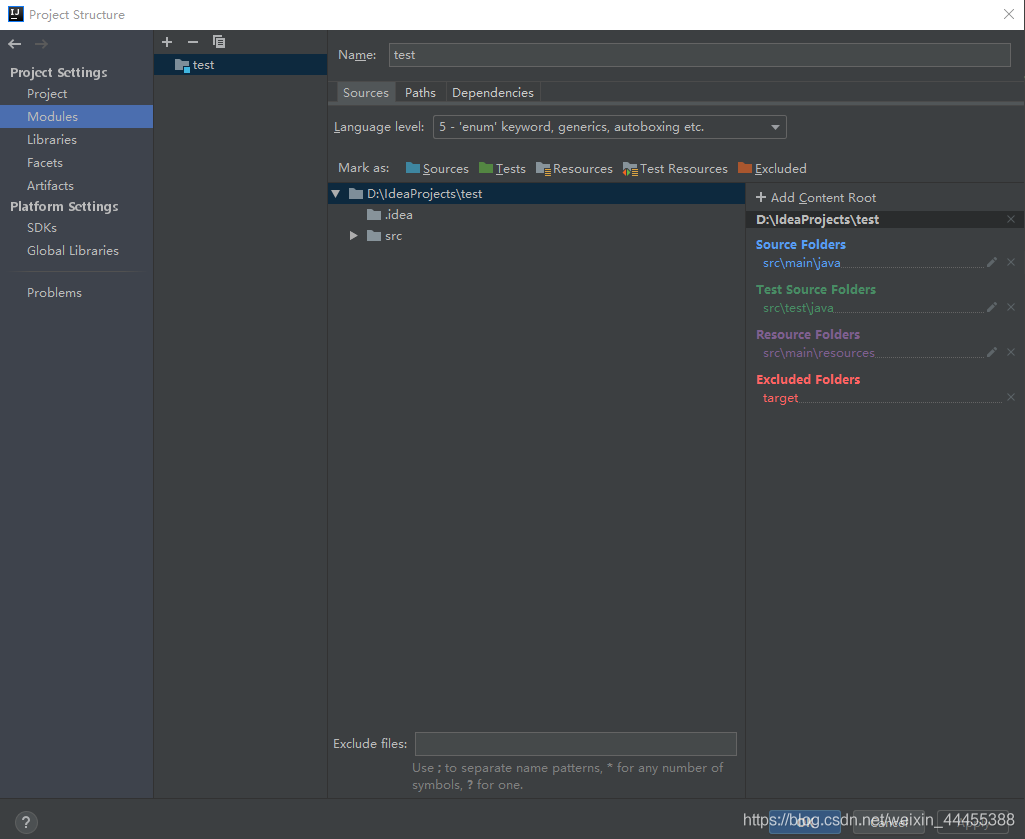

【代码】idea如何将外部jar包打包。

一、目的 远程客户端编写MapReduce代码,并且配置环境进行调试。 ...2.加载对应CDH需求依赖 <?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/PO...

当我们实现了一个Hadoop MapReduce Job以后,而这个Job可能又依赖很多外部的jar文件,在Hadoop集群上运行时,有时会出现找不到具体Class的异常。出现这种问题,基本上就是在Hadoop Job执行过程中,没有从执行的上...

1. 最简单的方式是所有...2. 使用hadoop jar的-libjars参数来设置第三方依赖的jar hadoop jar my-example.jar com.example.MyTool -libjars mysql-connector-java.jar,abc.jar 多个jar包间使用逗号分

当我们实现了一个Hadoop MapReduce Job以后,而这个Job可能又依赖很多外部的jar文件,在Hadoop集群上运行时,有时会出现找不到具体Class的异常。出现这种问题,基本上就是在Hadoop Job执行过程中,没有从执行的上...

管理包依赖是 Maven 核心功能之一,下面通过如何引入 jar 包;如何解析 jar 包依赖;包冲突是如何产生;如何解决包冲突;依赖管理解决什么问题;什么是依赖范围;使用包依赖的最佳实践等 6 个问题来介绍。 如何引入 ...

背景 开发的flink程序,要...想将应用程序jar包和依赖jar包分开,依赖的jar包在提交时一起提交上去(像spark on yarn直接指定“–jars”这样),但是找了好久发现flink官方没有提供这样的方式。 直接将依赖的ja...

在Spark应用中,我们发现,在${SPARK_HOME}\lib文件夹中添加jar包时并不起作用。那么,要如何使得我们编写的Sparky应用依赖的jar有效呢?有如下四种方案: 1.使用参数–jars 添加本地的第三方jar文件(运行spark-...

在使用这些框架时,需要根据具体的需求选择相应的依赖包,并将其添加到项目中。同时,还需要注意依赖包的版本兼容性,以避免出现不兼容的情况。 ### 回答2: Spark和Flink都是流行的大数据处理框架,它们都支持在...

1、在pom.xml 中添加打包插件 <build> <plugins> <plugin> <artifactId>maven-compiler-plugin</artifactId> <version>2.3.2<...

maven-assembly-plugins 解决依赖第三方jar包,并可执行jar的打包pom.xml配置如下: pom.xml配置如下: <build> <resources> <resource> <targetPath>${project.build.directory}...

我们可以在使用“hadoo jar”命令时,向启动的job传递“libjars”选项参数,同时配合ToolRunner工具来解析参数并运行Job,这种方式是推荐的用法之一,因为它可以简单的实现job的依赖包和hadoop classpath解耦,可以...

当我们无法从本地仓库找到需要的构件的时候,就会从远程仓库下载构件至本地仓库。一般地,对于每个人来说,书房只有一个,但外面的书店有很多,类似第,对于Maven来说,每个用户只有一个本地仓库,但可以...

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation=...

推荐文章

- python判断sqlite数据库是否存在_sqlite3 判断数据库是否存在-程序员宅基地

- android多级树形列表-程序员宅基地

- 《成为一名机器学习工程师》_成为机器学习的拉斐尔·纳达尔-程序员宅基地

- Debian11-jenkins+python+allure自动化搭建_debian11 源 tencent-程序员宅基地

- JavaScript设计模式系统讲解与应用-笔记_javascript 设计模式系统讲解与应用 课程-程序员宅基地

- sepl 3.0,全方位全能型计算机语言_sepl无人编程-程序员宅基地

- java comtext_Java中的上下文对象设计模式(Context Object Design Pattern)-程序员宅基地

- lldp中与snmp相关内容agentx-程序员宅基地

- 关闭Mysql的root用户远程访问授权报错Duplicate entry localhost-root for key PRIMARY_error 1062 (23000): duplicate entry 'localhost-roo-程序员宅基地

- LeetCode 818. Race Car-程序员宅基地